As deepfakes tem conquistado a atenção pelo seu valor de entretenimento e criativo, mas elas também apresentam sérios riscos para os negócios

Por Mario Cesar Santos

A ascensão do deepfake ameaça significativamente as pessoas e empresas por meio de vídeos e imagens criados por inteligência artificial.

Fraudadores e cibercriminosos estão encontrando aplicações de violação de dados para gerar deepfakes que têm o potencial de causar danos generalizados.

Ao explorar a credibilidade e a autenticidade destes meios de comunicação fraudulentos, estas peças de deepfakes podem enganar, manipular e defraudar as organizações e seus clientes.

Compreender as formas como os deepfakes podem ser usados contra os seus clientes é crucial para que as empresas possam desenvolver estratégias eficazes para mitigar o seu impacto e proteger contra a sua utilização indevida.

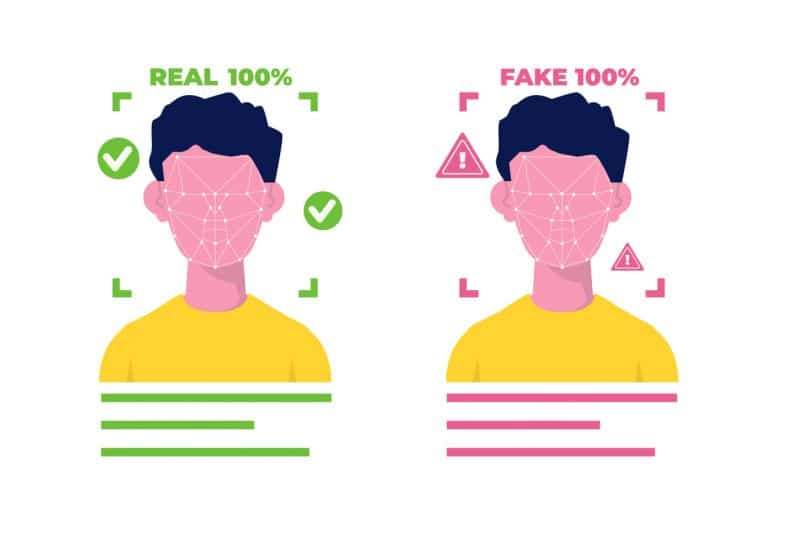

O termo “deepfake” tem origem na combinação “aprendizado profundo” e “falso”. Embora não tenha uma definição universalmente aceita, um deep fake geralmente significa que uma pessoa presente em conteúdo existente é substituída pela imagem de outra pessoa.

Essencialmente, uma deep fake é um conteúdo como uma foto, áudio ou vídeo que foi manipulado por Machine Learning (ML) e Inteligência Artificial (IA) para fazer parecer ser algo que não é.

Embora as deepfakes tenham conquistado a atenção pelo seu valor de entretenimento e criativo, elas também apresentam sérios riscos para os negócios. Nossa ideia aqui é listar algumas maneiras pelas quais atores mal-intencionados podem explorar esta modalidade de fraude online:

Conteúdo fraudulento: uma das ameaças mais imediatas das deepfakes é o seu uso potencial na criação de conteúdo fraudulento. Atores maliciosos podem se passar por indivíduos em vídeos, fazendo parecer que estão dizendo ou fazendo coisas que nunca fizeram. No nível pessoal ou empresarial, isto pode ser usado para espalhar informações falsas e prejudicar reputações de pessoas e marcas;

Ataques de engenharia social: Deepfakes também podem ser usadas em ataques de engenharia social, onde os invasores manipulam indivíduos para divulgar informações confidenciais ou realizar ações prejudiciais. Por exemplo, um vídeo deepfake poderia ser usado para se passar por um CEO de uma grande companhia instruindo um funcionário a transferir fundos para uma conta fraudulenta;

Campanhas de desinformação: Deepfakes podem ser usadas como arma em campanhas de desinformação para manipular a opinião pública. Ao criar vídeos convincentes de figuras políticas ou outras figuras públicas dizendo ou fazendo coisas que não fizeram, os atores mal-intencionados podem semear o caos e a confusão;

Roubo de identidade: Deepfakes podem ser usadas para roubar a identidade de alguém, criando vídeos ou imagens falsas que parecem ser do indivíduo. Isto poderia ser usado para acessar contas confidenciais ou cometer outras formas de fraude;

Sabotagem e espionagem: Deepfakes também podem servir para fins de sabotagem ou espionagem de toda ordem. Por exemplo, um vídeo deepfake pode ser usado para manipular o preço das ações de uma empresa ou prejudicar a sua reputação.Os indivíduos e organizações necessitam estar cientes desses riscos e tomar as medidas necessárias para se protegerem, como usar métodos de autenticação fortes (como biometria) e serem altamente cautelosos com este tipo de mídia manipulada. Para os consumidores, isto significa escolher fornecedores e soluções que considerem estas ameaças e que possam oferecer uma proteção robusta contra estas ameaças. Para os líderes empresariais, é essencial, portanto, considerar estas preocupações e tomar as medidas necessárias para proteger os clientes e os seus negócios. Uma dessas ações inclui a integração da tecnologia de autenticação biométrica nas soluções e ofertas existentes. E como a biometria ajuda a se defender das deepfakes? Vamos listar as possibilidades principais:

Detecção de vivacidade – é um componente crucial da autenticação biométrica que ajuda a garantir a autenticidade dos dados biométricos capturados. Esta tecnologia foi projetada para detectar se uma amostra biométrica, como uma imagem facial ou uma gravação de voz, vem de uma pessoa viva ou de uma reprodução, manipulação ou deepfake. Os algoritmos de detecção de vivacidade analisam vários fatores, como a presença de movimentos naturais em uma imagem facial ou a presença de sinais fisiológicos em uma gravação de voz, para determinar se os dados biométricos são de uma pessoa viva. Esses algoritmos também protegem contra ataques de injeção ou emulação. Quando se trata de ameaças de deepfake, a detecção de vivacidade é essencial para evitar que atores mal-intencionados utilizem imagens estáticas ou vídeos pré-gravados para falsificar sistemas de autenticação biométrica. Ao verificar a vivacidade da pessoa que fornece a amostra biométrica, a tecnologia de detecção de vivacidade ajuda na defesa contra ataques deep fake e garante a integridade do processo de autenticação.

Biometria comportamental – envolve a análise de padrões no comportamento de um indivíduo, como velocidade de digitação, movimentos do mouse e padrões de deslizamento em um dispositivo touchscreen. Esses padrões comportamentais são únicos para cada indivíduo e podem ser usados para verificar sua identidade. Quando aplicada à detecção de deepfakes, a biometria comportamental pode ajudar a identificar anomalias no comportamento do usuário que podem indicar que um vídeo ou imagem foi manipulado;

Reconhecimento de voz – ao analisar vários aspectos da voz de uma pessoa, como volume, tom e cadência, os sistemas de reconhecimento de voz podem verificar a validade deste identidade. No contexto da detecção de deep fake, este método pode ajudar a identificar padrões de fala não naturais ou inconsistentes que podem indicar que uma gravação de vídeo ou áudio foi manipulada. Biometria multi-modal pode contribuir de forma decisiva para combater essas ameaças.

Biometria multimodal – envolve a combinação de vários métodos de autenticação biométrica para aumentar a segurança. Ao utilizar uma combinação de reconhecimento facial, reconhecimento de voz e biometria comportamental, por exemplo, é possível obter uma defesa mais robusta contra ameaças de deep fake. Ao exigir múltiplas formas de autenticação biométrica, esses sistemas podem tornar mais difícil para atores mal-intencionados criarem peças de deepfakes convincentes;

5 dicas para empresas se protegerem de roubo de dados na internet

Protegendo-se contra invasões de dados do CadSus: estratégias e alertas por Longinus Timochenco