No Brasil, o TSE, atento aos riscos dessas tecnologias nas eleições, decidiu proibir o uso de deepfakes no período eleitoral

A tecnologia de deepfake, que utiliza inteligência artificial e pode ser usada para criar vídeos, áudios e imagens falsas com uma aparência extremamente realista, tem se tornado uma preocupação crescente, especialmente nas redes sociais. Esse avanço tecnológico, que inicialmente parecia inofensivo, agora levanta questões sobre desinformação e manipulação.

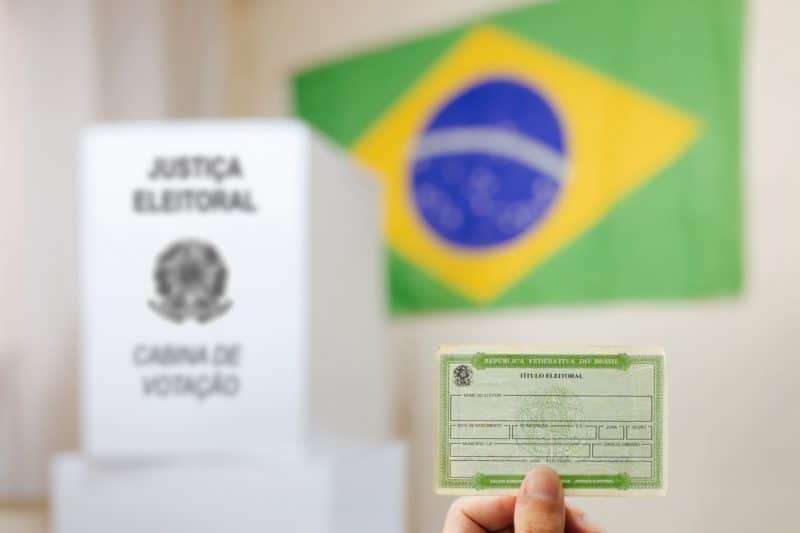

No Brasil, o Tribunal Superior Eleitoral (TSE), atento aos riscos dessas tecnologias nas eleições, decidiu proibir o uso de deepfakes nas eleições municipais de 2024. De acordo com a Kaspersky, houve um aumento de 900% no número de vídeos online utilizando deepfakes para aplicar golpes em 2023.

Recentemente, o bilionário Elon Musk, dono da rede social X, compartilhou um vídeo manipulado envolvendo a vice-presidente dos Estados Unidos, Kamala Harris, demonstrando o potencial perigoso dessa ferramenta.

O vídeo em questão mostrava uma narração falsificada de Harris, onde ela supostamente fazia declarações ofensivas e inverídicas sobre o presidente Joe Biden. Embora o vídeo tenha sido originalmente postado como uma “paródia”, a republicação de Musk, sem o devido esclarecimento, gerou confusão entre os usuários.

Com mais de 130 milhões de visualizações, o caso exemplifica como deepfakes podem ser facilmente disseminados, alimentando desinformação e influenciando a opinião pública, especialmente em tempos de eleições.

A inteligência artificial por trás dos deepfakes funciona aprendendo padrões de voz, expressões faciais e gestos de uma pessoa real, criando conteúdos falsos que parecem autênticos. Esse tipo de manipulação já não se limita a celebridades ou figuras públicas, mas pode atingir qualquer pessoa, colocando em risco reputações e até a segurança pessoal.

Preocupações

O advogado especialista em direito digital pela FGV, Lucas Maldonado D. Latini, alerta que a falta de uma legislação pode deixar brechas para que deepfakes sejam utilizados de forma maliciosa, seja para fins políticos, econômicos ou pessoais.

Até o momento, a única legislação que rege sobre a temática é a Resolução 23.732/2024, do TSE, que disciplinou o uso de IA nas eleições deste ano e apenas tem incidência no contexto eleitoral.

O Marco Civil da Internet (Lei nº 12.965/2014) estabelece que as redes sociais e outros provedores de aplicações não são automaticamente responsáveis pelo conteúdo gerado por terceiros. Em vez disso, essas plataformas só podem ser responsabilizadas se não agirem para remover o conteúdo após receberem uma ordem judicial ou uma notificação específica.

Quando uma plataforma recebe uma dessas notificações, ela precisa agir rápido para evitar que esse material se espalhe ainda mais. Se não fizer isso, pode acabar sendo responsabilizada pelos danos que o conteúdo causar.

Mas identificar e remover conteúdos enganosos, como deepfakes, não é nada fácil. Com tanto material sendo compartilhado a todo momento, muitos desses vídeos e imagens são tão bem-feitos que é difícil saber se são reais ou não. Isso pode fazer com que as plataformas demorem ou até falhem em responder de forma adequada, complicando ainda mais o combate a esse tipo de conteúdo.

IA auxilia na detecção precoce de demência por EEGs

Aixia e Pure Storage revolucionam com projetos, incluindo uso de IA em fabricação de cerveja

Acompanhe o melhor conteúdo sobre Inteligência Artificial publicado no Brasil.

Cadastre-se para receber o IDNews e acompanhe o melhor conteúdo do Brasil sobre Identificação Digital! Aqui!