Mitigando a crescente ameaça à segurança biométrica representada por imagens digitais falsas e ataques de injeção

Deepfakes são imagens digitais renderizadas – como efeitos especiais em um filme – que permitem que um fraudador crie vídeos realistas e os use para burlar a autenticação biométrica.

As preocupações com a fraude estão crescendo à medida que a tecnologia para criar deepfakes se torna cada vez mais acessível.

A ameaça de deepfakes é substancial

Novos dados de uma pesquisa da ID R&D mostram que 91% das empresas reconhecem que elas ou seus clientes estão preocupados com fraudes com deepfake, com 42% já enfrentou esse tipo de ataque.

Além disso, 84% dos mesmos entrevistados expressam preocupação semelhante sobre ataques de injeção, com 37% tendo exposição em primeira mão.

Em 2023, 20% dos ataques bem-sucedidos de controle de contas usarão deepfakes – Gartner.

Este artigo apresenta vários tipos de deepfakes, como eles são usados em ataques para burlar a segurança biométrica e como a ameaça é mitigada.

Para uma explicação ainda mais detalhada, consulte o white paper em inglês.

Geração de imagens fraudulentas: deepfakes e cheapfakes

Deepfakes são um tipo de mídia sintética em rápida evolução, na qual a inteligência artificial (IA) é usada para gerar imagens digitais de aparência realista que retratam pessoas existentes fazendo ou dizendo coisas que nunca fizeram ou disseram, ou até mesmo fabricando pessoas que realmente não existem.

Segundo o Instituto de Pesquisas Idiap, 95% dos sistemas de reconhecimento facial são incapazes de detectar deepfakes.

Ao contrário de fotos e replays de tela que são “apresentados” à câmera em um meio físico (um ataque de apresentação), os deepfakes são nativamente digitais, criados usando aprendizado de máquina baseado em rede neural profunda.

Deepfakes realistas podem ser “injetados” em um dispositivo por meio de hacks de hardware e software de uma forma que contorna a câmera (um ataque de injeção), o que os torna difíceis de detectar pelos métodos de detecção de ataques de apresentação.

Cheapfakes são uma classe de mídia falsa que é fácil e rápida de produzir, especialmente para usuários amadores. Em comparação com os deepfakes tradicionais, os cheapfakes não requerem codificação sofisticada, ajuste manual da rede neural ou habilidades de pós-produção.

Os especialistas destacam que falsificações baratas podem ser perigosas porque exigem pouco esforço e custo para serem fabricadas.

Utilização de imagens fraudulentas: ataques de apresentação e ataques de injeção

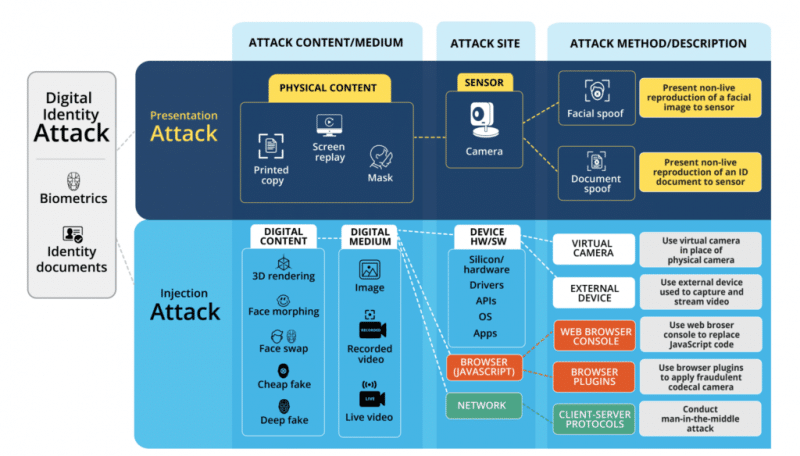

Existem duas classes de ataques em sistemas biométricos que visam falsificar a biometria burlando a detecção de liveness: ataques de apresentação e ataques de injeção.

Ataques de apresentação envolvem “apresentar” imagens não vivas para a câmera durante o processo de captura e representá-las como ao vivo usando uma mídia física, como fotos em papel e telas digitais.

Ataques de injeção envolvem hacks de hardware ou software que permitem que o fraudador “injete” imagens digitais de forma que ignore um processo de captura adequado com a câmera principal.

Considere um ataque análogo em que uma transmissão via satélite de um discurso ao vivo de um líder político é interceptada e substituída por um vídeo digital deepfake dele dizendo outra coisa.

O público acredita estar assistindo a um discurso ao vivo de seu líder, quando na verdade está assistindo a um discurso gravado de um deepfake dizendo algo diferente. A detecção de ataques de injeção ajuda a mitigar essa ameaça no domínio da segurança biométrica.

A injeção de imagens falsas pode ocorrer em qualquer um dos vários pontos de ataque em um dispositivo usando hacks de hardware ou software. Exemplos de ataques de injeção são:

Mitigando o risco: detectando ataques

| Ataques de hardware | Ataques de software | Ataques de rede |

|---|---|---|

| Uso de uma câmera externa no lugar da câmera principal do dispositivo Interceptação e substituição de sinais no nível do chip e pin do dispositivo | Uso de uma câmera virtual no lugar da câmera principal do dispositivo Interceptação e substituição de sinais no driver, API e camada do sistema operacional Console do navegador e hacks de plugins | Interceptação e substituição de sinais na camada de rede (por exemplo, ataque man-in-the-middle) |

Ao contrário da mídia física usada para ataques de apresentação, como fotos e telas em papel, deepfakes e conteúdos digitais relacionados representam um tipo diferente de ameaça. Enquanto deepfakes possam ser usados em ataques de apresentação de replay de tela, eles podem ser mitigados com o PAD. No entanto, eles também podem ser usados em ataques de injeção que, conforme descrito acima, contornam a câmera e, portanto, necessitam de diferentes métodos de detecção.

Com a evolução dos deepfakes, as contramedidas para combatê-los também avançaram. Existem vários métodos, dependendo dos dados disponíveis para análise:

1 Análise multimodal

A IA analisa o movimento dos lábios e o formato da boca para detectar discrepâncias.

2 Técnicas de marca d’água e assinatura digital

Esses métodos exigem o cálculo de um hash ou o uso de uma técnica que incorpora um sinal ou código digital oculto em um vídeo que pode ser usado para identificar a origem do vídeo.

3 Análise de vídeo

Isso inclui um amplo espectro de diferentes abordagens baseadas em aprendizado de máquina e redes neurais profundas, incluindo análise de movimento, análise quadro a quadro e detectores de artefatos de imagem.

4 Detecção de ataque de injeção digital

Esses métodos são baseados na detecção do desvio do processo de captura normal de uma câmera adequada, conforme descrito acima. Eles podem coletar informações adicionais do sistema operacional, navegador e qualquer software e hardware usado para captura de vídeo. Uma ampla gama de informações é coletada e comparada com aquela conhecida por ser uma captura adequada e conhecida por ser um ataque de injeção.

Resumindo: uma abordagem abrangente para vivacidade inclui detecção de ataques de apresentação e injeção

Por fim, a importância de proteger a segurança biométrica contra deepfakes e ataques de injeção não pode ser colocada de lado, dado o rápido avanço e a proliferação do software de renderização deepfake. Deepfakes têm o potencial de comprometer seriamente a autenticação biométrica e é crucial que as organizações tomem medidas para se proteger contra eles.

Ao usar a detecção de ataque de apresentação em conjunto com a detecção de ataque de injeção, as organizações podem garantir melhor a integridade de seus sistemas.

Sobre ID R&D

ID R&D, uma empresa Mitek, é um fornecedor premiado de biometria de voz e facial baseada em IA e detecção de liveness. Com uma das mais fortes equipas de P&D da indústria, a ID R&D fornece consistentemente capacidades biométricas inovadoras e de primeira classe que elevam o nível em termos de usabilidade e desempenho. Nossos produtos alcançaram resultados superiores em desafios líderes do setor, testes de terceiros e implementações no mundo real em mais de 70 países. As soluções da ID R&D estão disponíveis para fácil integração para mobile, web, mensageiros, e canais telefônicos, bem como em smart speakers set-top boxes, e outros dispositivos IoT. A ID R&D está sediada em Nova Iorque, NY. Saiba mais em www.idrnd.ai.

Outros Artigos da ID R&D, leia aqui!